فایل Robots.txt یک فایل متنی است که وب مسترها از آن برای آموزش ربات های وب (معمولاً ربات های موتور جستجو) و نحوه خزیدن crawler های گوگل در صفحات وب سایت خود ایجاد می کنند. تفاوتی ندارد حتی اگر شما فروشگاه اینترنتی هم دارید این آموزش برای شما صدق می کند.

فایل robots.txt بخشی از پروتکل ربات های (REP) است ، گروهی از استانداردهای وب که چگونگی خزیدن روبات ها در وب ، دسترسی و فهرست بندی مطالب را تنظیم می کند و آن محتوا را در اختیار کاربران قرار می دهد. REP شامل راهنمایی هایی مانند روبات های متا ، و همچنین دستورالعمل هایی درمورد نحوه برخورد موتورهای جستجو با پیوندها (مانند “follow” یا “nofollow”) می باشد و انواع تگ های دیگر می باشد.

کار پرونده های robot.txt چیست؟

در عمل ،فایل های robots.txt نشان می دهند که آیا برخی از کاربران (خزندگان وب) می توانند یا نمی توانند قسمت هایی از یک وب سایت را پیمایش کنند یا نه. این دستورالعمل های خزیدن با “مجاز نبودن” یا “مجاز” کردن رفتار برخی از عوامل مشخص می شوند.

قالب اصلی:

User-agent: [user-agent name]

Disallow: [URL string not to be crawled]

این دو خط با هم ، یک پرونده کامل robots.txt به حساب می آیند – هرچند که یک پرونده روبات می تواند حاوی چندین خط از عوامل و دستورالعمل های کاربر باشد (به عنوان مثال ، اجازه نمی دهد ، اجازه می دهد ، تاخیر در خزیدن و غیره).

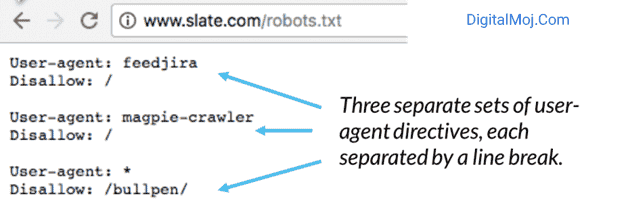

در یک پرونده robots.txt ، هر مجموعه از دستورالعمل های عامل به عنوان یک مجموعه گسسته، به صورت یک خط جدا از هم ظاهر می شوند:

در یک فایل robots.txt چندین دستورالعمل متفاوت برای خزندگان گوگل وجود دارد که، مشخص می کند کدام عنصر برای پیمایش مجاز هست یا مجاز نیست. در شکل زیر یک سری دستورالعمل وجود دارد که فقط مربوط به کاربران (بازدید کنندگان) می باشد. اگر پرونده حاوی یک قاعده است که برای بیش از یک عامل اعمال می شود ، یک خزنده فقط به خاص ترین گروه دستورالعمل ها توجه خواهد کرد (و دستورالعمل ها را دنبال می کند).

در اینجا مثالی وجود دارد:

مثال robots.txt:

در اینجا چند نمونه از اقدامات فایل robots.txt برای سایت www.digitalmoj.com آورده شده است:

Robots.txt: www.kitwp.com/robots.txt

- مسدود کردن همه خزنده وب از همه محتوا:

عامل کاربر: *

عدم اجازه: /

استفاده از این ترکیب در یک پرونده robots.txt به همه خزندگان وب می گوید که هیچ صفحهای را در www.digitalmoj.com ، از جمله صفحه اصلی ، خزش نکنند. - اجازه دسترسی همه خزندگان وب به همه محتوا:

عامل کاربر: *

رد کردن:

استفاده از این ترکیب در یک فایل robots.txt به خزندگان وب می گوید که تمام صفحات در www.digitalmoj.com ، از جمله صفحه اصلی ، را خز کنند. - مسدود کردن یک خزنده وب خاص از یک پوشه خاص:

نماینده کاربر: Googlebot

غیرفعال کردن: / مثال-زیر پوشه /

این نحوه فقط به خزنده گوگل (نام کاربری Googlebot) می گوید هیچ صفحه ای را که حاوی رشته URL www.kitwp.com/example-subfolder/ است ، خزش نکنند. - مسدود کردن خزش یک خزنده خاص از یک صفحه وب خاص:

نماینده کاربر: Bingbot

عدم اجازه: /example-subfolder/blocked-page.html

این نحوه فقط به خزنده بینگ (نام کاربر عامل بینگ) می گوید که از خزیدن صفحه خاص در www.kitwp.com/example-subfolder/blocked-page جلوگیری کند.

robots.txt چگونه کار می کند؟

موتورهای جستجو دارای دو شغل اصلی هستند:

1.خزیدن در وب سایت ها برای کشف محتوا:

نمایه سازی از آن محتوا به گونه ای که می تواند در اختیار جستجوگرانی باشد که به دنبال اطلاعات هستند. برای خزیدن سایت های وردپرس ، موتورهای جستجو پیوندها را دنبال می کنند تا از یک سایت به سایت دیگر برسند – در نهایت، در نتایج به دست آمده میلیاردها پیوند و وب سایت مشاهده می کنید. این رفتار خزنده گاهی به عنوان “عنکبوت” شناخته می شود.

پس از رسیدن به یک وب سایت و البته قبل از اسپایدر کردن آن ، خزنده جستجو به دنبال فایل robots.txt میگردد. اگر یکی از آنها را پیدا کند، خزنده ابتدا قبل از ادامه ی خزش صفحه، آن پرونده را می خواند.

از آنجا که پرونده robots.txt حاوی اطلاعاتی در مورد چگونگی خزیدن موتور جستجو است، اطلاعات موجود در آنجا دستورالعمل های بیشتری را در مورد خزش این سایت خاص می دهد. اگر فایل robots.txt حاوی هیچگونه بخشنامه ای نباشد که فعالیت کاربر را برای دیدن محتوای آن صفحه مجاز می داند (یا اگر سایت فایل robots.txt ندارد) ، به خزیدن سایر اطلاعات در سایت ادامه می دهد.

نکته: برای یافتن یک فایل robots.txt باید آن را در بالاترین سطح فهرست وب سایت وردپرس قرار بگیرد.

Robots.txt به حروف کوچگ و بزرگ حساس است: پرونده باید دقیقا “robots.txt” نامگذاری شود (نه Robots.txt ، robots.TXT یا موارد دیگر). برخی از نمایندگان کاربر (روبات ها) ممکن است پرونده robots.txt شما را نادیده بگیرند. این امر به ویژه در مورد خزنده های مبهم تر مانند روبات های مخرب یا اسکنرهای آدرس ایمیل رایج است.

پرونده /robots.txt در دسترس عموم است: کافی است / انتهای /robots.txt را به انتهای هر دامنه اصلی اضافه کنید تا دستورالعمل های این وب سایت را مشاهده کنید (اگر این سایت دارای پرونده robots.txt است!). این بدان معنی است که هر کسی می تواند ببیند صفحات شما چه کاری انجام می دهند یا اینکه نمی خواهید بعضی از صفحات وبسایت وردپرس تان توسط خزنده ها خزش شوند ، بنابراین از آنها برای مخفی کردن اطلاعات شخصی کاربر استفاده نکنید.

هر زیر دامنه در یک دامنه root از پرونده های جداگانه robots.txt استفاده می کند. این بدان معنی است که هر دو blog.digitalmoj.com و shembull.com باید پرونده های robots.txt خود را داشته باشند و نمی شود که زیر دامنه ی یک سایت از فایل سایت مادر استفاده کند. (در blog.kitwp.com/robots.txt و مثال.com/robots.txt).

به طور کلی بهترین روش برای نشان دادن مکان نقشه های مرتبط با این دامنه در انتهای پرونده robots.txt است. در اینجا مثالی وجود دارد:

قواعد فنی robots.txt:

قواعد Robots.txt را می توان “زبان”فایل های robots.txt دانست. پنج اصطلاح رایج وجود دارد که به احتمال زیاد در پرونده روبات ها قرار دارد. آنها شامل موارد زیر هستند:

عامل کاربر: خزنده اختصاصی وب که شما به آن دستورالعمل های خزیدن (معمولاً موتور جستجو) را می دهید.

Disallow: دستورالعمل مورد استفاده برای گفتن به یک عامل کاربر برای غیر مجاز کردن خزیدن URL خاص. فقط برای هر URL یک خط “Disallow:” مجاز است.

Allow: (فقط برای Googlebot قابل اجرا است): این دستور برای اطلاع به Googlebot است و می تواند به یک صفحه یا زیر پوشه دسترسی پیدا کند حتی اگر خزش صفحه اصلی یا زیر پوشه آن مجاز نیست.

تاخیر در خزیدن:

چند ثانیه ای که باید یک خزنده منتظر بارگیری و خزیدن محتوای صفحه باشد. توجه داشته باشید که Googlebot این دستور را تأیید نمی کند ، اما سرعت خزیدن را می توان در کنسول جستجوی Google تنظیم کرد.

نقشه سایت:

برای تماس با موقعیت مکانی هر نقشه سایت XML (های) مرتبط با این URL استفاده می شود. توجه داشته باشید که این دستور فقط توسط Google ، Ask ، Bing و Yahoo پشتیبانی می شود.

6.تطبیق الگو:

هنگامی که می خواهید URL های واقعی را مسدود یا مجاز کنید ، فایل های robots.txt می توانند کاملاً پیچیده شوند زیرا به آنها اجازه می دهید تا از الگوی تطبیق برای پوشش طیف وسیعی از گزینه های ممکن URL استفاده کنند. Google و Bing هر دو از دو عبارت متفاوت که برای شناسایی صفحات یا زیر پوشه هایی که یک SEO یکسان می خواهد از آن استفاده کند ، استفاده می کنند.

robots.txt به کجا می رود؟

هر زمان که به یک سایت مراجعه می کنند ، موتورهای جستجو و سایر روبات های خزنده وب (مانند خزنده فیس بوک ، Facebook) می دانند که به دنبال فایل robots.txt هستند. اما، آنها فقط در یک مکان خاص به دنبال آن پرونده می گردند: فهرست اصلی (به طور معمول دامنه یا صفحه اصلی شما).

اگر یک نماینده کاربر به سایت www.kitwp.com/robots.txt مراجعه کند و پرونده ربات ها را در آنجا پیدا نکند ، فرض خواهد کرد که سایت فایلی مبنا بر محدودیت ندارد و با خزیدن در همه جای صفحه (و شاید حتی در کل سایت) ادامه یابد. حتی اگر صفحه robots.txt در، مثلاً مثال.com/index/robots.txt یا www.kitwp.com/homepage/robots.txt وجود داشته باشد ، توسط عوامل کاربر کشف نمی شود و به این ترتیب سایت کاملا پیمایش می شود. انگار اصلاً پرونده روبات ندارد.

برای اطمینان از یافتن پرونده robots.txt ، همیشه آن را در فهرست اصلی یا دامنه اصلی خود قرار دهید.

چرا به robots.txt احتیاج دارید؟

فایل های Robots.txt دسترسی خزنده را به مناطق خاصی از سایت شما کنترل می کنند. در حالی که اگر به طور تصادفی Googlebot را از خزیدن کل سایت وردپرس خود منع کنید ، ممکن است این بسیار خطرناک باشد ، برخی مواقع وجود دارد که یک پرونده robots.txt می تواند بسیار مفید باشد و در برخی از موارد نیز می تواند باعث بروز مشکلات زیادی در وب سایت وردپرس شما شود.

برخی موارد استفاده متداول شامل موارد زیر است:

جلوگیری از نمایش محتوای تکراری در SERP (توجه داشته باشید که روبات های متا معمولاً انتخاب بهتری برای این کار هستند)

بخشهای کامل وب سایت را خصوصی نگه دارید (به عنوان مثال ، سایت اصلی تیم مهندسی شما).

پنهان نگه داشتن صفحات نتایج جستجوی داخلی در SERP عمومی

مشخص کردن نقشه سایت (ها)

جلوگیری از ایندکس کردن فایل های خاص در وب سایت وردپرس خود از موتورهای جستجو (تصاویر ، PDF و غیره)

به منظور جلوگیری از بارگیری بیش از حد سرورهای شما هنگام خزش خزنده ها- بارها و بارها چندین مطالب را به طور همزمان بارگیری کنید-

نکته: اگر در سایت شما هیچ زمینه ای وجود ندارد که می خواهید دسترسی کاربر عامل را کنترل کنید ، ممکن است به هیچ وجه به فایل های robots.txt احتیاج نداشته باشید.

بررسی فایل robots.txt:

مطمئن نیستید که پرونده robots.txt دارید؟ به سادگی دامنه اصلی خود را تایپ کنید ، سپس / انتهای URL /robots.txt را اضافه کنید. به عنوان مثال ، پرونده روبات های Moz در moz.com/robots.txt قرار دارد.اگر هیچ صفحه .txt ظاهر نمی شود ، در حال حاضر صفحه (زنده) robots.txt ندارید.

نحوه ایجاد پرونده robots.txt در وب سایت وردپرس خود:

اگر فهمیدید که فایل robots.txt ندارید یا دارید و می خواهید تغییر دهید ، انجام آن یک فرآیند ساده است. این مقاله از Google در باب ایجاد فایل robots.txt نوشته شده است و به شما این امکان را می دهد تا تست کنید که آیا فایل شما به درستی تنظیم شده است یا خیر.

از فایل robot.txt برای انجام این کارها استفاده نکنید:

ازفایل robots.txt برای جلوگیری از نمایش داده های حساس (مانند اطلاعات کاربر خصوصی) در نتایج SERP استفاده نکنید. از آنجا که صفحات دیگر ممکن است به طور مستقیم به صفحه حاوی اطلاعات شخصی پیوند برقرار کنند (بنابراین با دور زدن دستورالعمل های robots.txt در دامنه اصلی یا صفحه اصلی خود) ، ممکن است همچنان ایندکس شوید.

اگر می خواهید صفحه خود را از جلو مسدود کنید، از روشی متفاوت مانند محافظت از رمز عبور یا دستورالعمل meta noindex استفاده کنید.

برخی موتورهای جستجو دارای چندین عامل کاربر هستند. به عنوان مثال ، Google از Googlebot برای جستجوی ارگانیک و Googlebot-Image برای جستجوی تصویر استفاده می کند.

بیشتر نمایندگان کاربر از همان موتور جستجو ارگانیک و معمول استفاده می کنند، بنابراین نیازی به تعیین دستورالعمل های مربوط به چندین خزنده برای موتورهای جستجو نیست ، اما داشتن توانایی انجام این کار به شما امکان می دهد چگونگی خزیدن محتوای سایت را تنظیم کنید.

یک موتور جستجو محتویات robots.txt را ذخیره می کند ، اما معمولاً حداقل یک بار در روز محتوای ذخیره شده را به روز می کند. اگر پرونده را تغییر دهید و می خواهید سریعتر از آنچه اتفاق می افتد ، آن را به روز کنید ، می توانید آدرس robots.txt خود را به Google ارسال کنید.

Robots.txt vs meta robots vs x-robots:

تفاوت بین این سه نوع دستورالعمل ربات چیست؟

فایل robots.txt یک فایل متنی واقعی است ، در حالی که روباتهای متا و ایکس رهنمودهای متا هستند. فراتر از آنچه در واقع هستند ، این سه ربات عملکردهای مختلفی دارند. Robots.txt رفتارهای خزنده سایت یا دایرکتوری را دیکته می کند ، در حالی که روبات های متا و x می توانند رفتار نمایه سازی را در سطح صفحه (یا عنصر صفحه) دیکته کنند.